Un debugger è uno strumento software che può aiutare il processo di sviluppo del software identificando gli errori di codifica nelle varie fasi del sistema operativo o dello sviluppo dell’applicazione.

Cosa verifica la presenza di errori in un programma?

Gli strumenti di debug servono per identificare il motivo per cui un programma non funziona correttamente o come previsto. Durante il debug, dobbiamo lavorare in modo sistematico ed eseguire il nostro programma con vari set di dati di test per trovare errori e correggerli quando li troviamo.

Quali sono i 3 tipi di errori in un programma?

Durante lo sviluppo di programmi possono verificarsi tre tipi di errore: errori di sintassi. errori logici errori logici Gli errori logici si verificano quando c’è un errore nella logica o nella struttura del problema. Gli errori logici di solito non causano l’arresto anomalo di un programma. Tuttavia, gli errori logici possono far sì che un programma produca risultati imprevisti. errori di runtime.

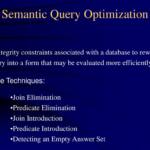

Quali sono le 3 tecniche di rilevamento degli errori?

Tecniche di rilevamento degli errori Esistono tre tecniche principali per rilevare gli errori nei frame: controllo di parità, checksum e controllo di ridondanza ciclica (CRC).

Quali sono i 2 tipi di errori?

Cosa sono gli errori di tipo I e di tipo IIErrore di tipo IIUn errore di falso negativo, o falso negativo, è un risultato del test che indica erroneamente che una condizione non è valida. Ad esempio, quando un test di gravidanza indica che una donna non è incinta, ma lo è, o quando una persona colpevole di un reato viene assolta, questi sono falsi negativi.https://en.wikipedia.org › Falsi_positivi_e_falsi_negativiFalsi positivi e falsi negativi – Wikipedia? In statistica, un errore di tipo I significa rifiutare l’ipotesi nulla quando è effettivamente vera, mentre un errore di tipo IIsignifica non rifiutare l’ipotesi nulla quando in realtà è falsa.

Qual è il metodo più comune di rilevamento degli errori?

Una delle tecniche più comuni per rilevare gli errori di trasmissione è una tecnica nota come controllo di ridondanza ciclico (CRC).

Cos’è il codice di errore nella programmazione?

Quanti tipi sono errori?

Generalmente gli errori sono classificati in tre tipi: errori sistematici, errori casuali e svarioni.

Quali sono le 4 fonti di errore?

Le comuni fonti di errore includono strumentali, ambientali, procedurali e umane. Tutti questi errori possono essere casuali o sistematici a seconda di come influenzano i risultati.

Cos’è un errore di tipo Python?

Il Python TypeError è un’eccezione che si verifica quando il tipo di dati di un oggetto in un’operazione è inappropriato. Questo può accadere quando un’operazione viene eseguita su un oggetto di tipo errato o non è supportata per l’oggetto.

Quali sono gli errori Quali sono i suoi tipi nel computer?

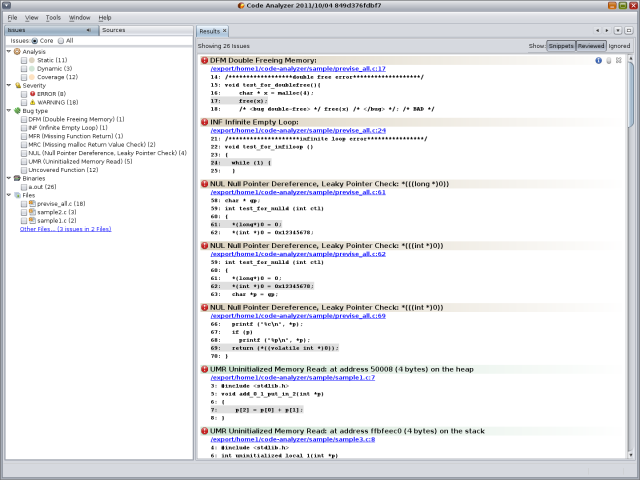

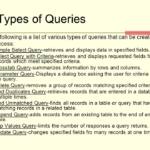

Esistono diversi tipi di errori, o bug, che possono impedire ai programmi del computer di funzionare come dovrebbero. Tre dei principali tipi di errore sono runtime , syntax e semantic .

Come rilevi e correggi gli errori?

Come rilevare e correggere gli errori? Per rilevare e correggere gli errori, vengono aggiunti ulteriori bit ai bit di dati al momento della trasmissione. I bit aggiuntivi sono chiamati bit di parità. Consentono di rilevare o correggere gli errori.

Quale tecnica viene utilizzata per la correzione degli errori?

La correzione degli errori può essere gestita in due modi: Correzione degli errori all’indietro: una volta scoperto l’errore, il destinatario richiede al mittente di ritrasmettere l’intera unità di dati. Correzione degli errori in avanti: in questo caso, il destinatario utilizza il codice di correzione degli errori checorregge automaticamente gli errori.

Cos’è il metodo di analisi degli errori?

Cos’è l’analisi degli errori? L’analisi degli errori è un metodo utilizzato per documentare gli errori che compaiono nella lingua dello studente, determinare se tali errori sono sistematici e (se possibile) spiegare cosa li ha causati.

Qual è il metodo più comune di rilevamento degli errori?

Una delle tecniche più comuni per rilevare gli errori di trasmissione è una tecnica nota come controllo di ridondanza ciclico (CRC).

Come vengono misurati gli errori?

La differenza tra il valore reale e il valore stimato di una grandezza è nota come errore di misura. Un errore può essere positivo o negativo. La deviazione della quantità misurata dalla quantità effettiva o dal valore vero è chiamata errore.

Quali sono i due principali metodi di correzione degli errori?

La correzione degli errori può essere gestita in due modi: Correzione degli errori all’indietro: una volta scoperto l’errore, il destinatario richiede al mittente di ritrasmettere l’intera unità di dati. Correzione degli errori in avanti: in questo caso, il destinatario utilizza il codice di correzione degli errori che corregge automaticamente gli errori.

Qual è il miglior rilevamento degli errori?

Il metodo di rilevamento degli errori più noto è chiamato parità, in cui un singolo bit in più viene aggiunto a ciascun byte di dati e assegnato un valore di 1 o 0, in genere a seconda che vi sia un numero pari o dispari di “1 ” bit.

Quali sono i 2 tipi di errori?

Cosa sono gli errori di tipo I e di tipo IIErrore di tipo IIUn errore di falso negativo, o falso negativo, è un risultato del test che indica erroneamente che una condizione non è valida. Ad esempio, quando un test di gravidanza indica che una donna non è incinta, ma lo è, o quando una persona colpevole di un reato viene assolta, si tratta di falsi negativi.https://en.wikipedia.org ›Falsi_positivi_e_falsi_negativiFalsi positivi e falsi negativi – Wikipedia? In statistica, un errore di tipo I significa rifiutare l’ipotesi nulla quando è effettivamente vera, mentre un errore di tipo II significa non rifiutare l’ipotesi nulla quando è effettivamente falsa.

Quali sono le 4 fonti di errore?

Le comuni fonti di errore includono strumentali, ambientali, procedurali e umane. Tutti questi errori possono essere casuali o sistematici a seconda di come influenzano i risultati.

Cos’è un controllo degli errori?

Un test di controllo degli errori è un test attitudinale che valuta la tua capacità di individuare errori in set di dati o testo. Le tipiche domande che sorgono durante queste valutazioni richiedono un efficace confronto tra informazioni corrette e una versione adattata del testo originale.

Cos’è il checksum nella programmazione?

Un checksum è un valore che rappresenta il numero di bit in un messaggio di trasmissione e viene utilizzato dai professionisti IT per rilevare errori di alto livello all’interno delle trasmissioni di dati. Prima della trasmissione, a ogni dato o file può essere assegnato un valore di checksum dopo aver eseguito una funzione hash crittografica.